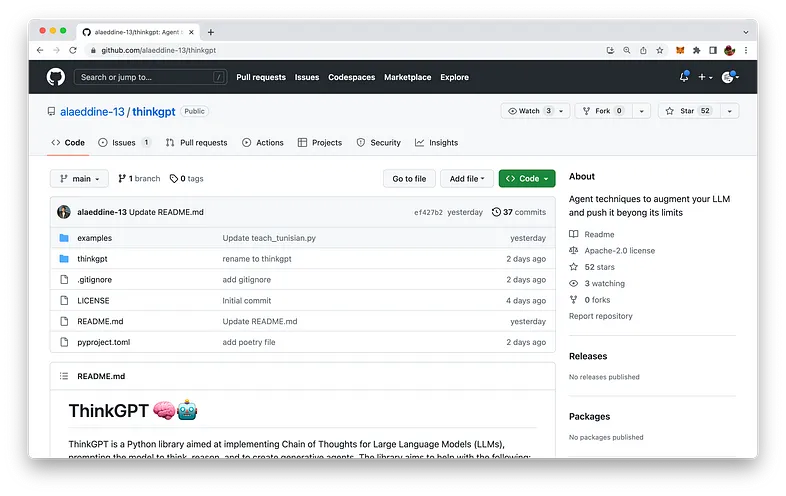

ThinkGPT คืออะไร? ThinkGPT นั้นเป็นนวัตกรรมใหม่ของไลบรารี Python ที่สามารถเพิ่มขีดความสามารถของโมเดลภาษาขนาดใหญ่ ทำให้สามารถคิด ให้เหตุผล และดำเนินการได้อย่างมีประสิทธิภาพมากขึ้น

ThinkGPT นั้นโฮสต์อยู่บน GitHub คุณสามารถเข้าไปดูได้ที่: https://github.com/alaeddine-13/thinkpt

คุณสมบัติเด่นๆ ของ ThinkGPT:

- หน่วยความจำ: ThinkGPT นั้นช่วยให้โมเดลภาษาขนาดใหญ่ (LLM) สามารถจดจำประสบการณ์และเรียนรู้แนวคิดใหม่ๆ ได้

- การปรับแต่งด้วยตนเอง: คุณลักษณะนี้ช่วยให้โมเดลสามารถปรับปรุงเนื้อหาที่สร้างขึ้นโดยการระบุคำวิจารณ์ แก้ไขปัญหา และปรับความเข้าใจให้ละเอียดยิ่งขึ้น

- Abstraction: ส่งเสริมให้ LLM สรุปกฎจากตัวอย่างหรือการสังเกต ช่วยสร้างความรู้แบบบีบอัดที่เหมาะกับความยาวบริบทที่จำกัดของโมเดล

- การอนุมาน: ช่วยให้ LLM สามารถคาดเดาอย่างมีการศึกษาโดยอิงจากข้อมูลที่มี

- เงื่อนไขในภาษาธรรมชาติ: ผู้ใช้สามารถแสดงงานและเงื่อนไขในภาษาธรรมชาติได้อย่างง่ายดาย ช่วยให้โมเดลตัดสินใจได้อย่างชาญฉลาด

- ติดตั้งง่ายและ Pythonic API: ต้องขอบคุณ DocArray ที่ทำให้ ThinkGPT มีกระบวนการติดตั้งที่ง่ายมากและมี Pythonic API

การติดตั้ง

ขั้นตอนการติดตั้ง ThinkGPT นั้นง่ายมากๆ คุณสามารถติดตั้งได้โดยการใช้ pip

pip install git+https://github.com/alaeddine-13/thinkgpt.git

คำสั่งนี้จะติดตั้งไลบรารี ThinkGPT โดยตรงจาก GitHub repository

ขั้นตอนแรกในการใช้ ThinkGPT ในสคริปต์ Python ของคุณ

เมื่อการติดตั้งเสร็จสิ้น คุณสามารถเริ่มใช้ ThinkGPT ในสคริปต์ Python ของคุณได้ ในการทำเช่นนี้ เพียงนำเข้าคลาส ThinkGPT จากโมดูล thinkgpt.llm และสร้างอินสแตนซ์ใหม่ของคลาส:

from thinkgpt.llm import ThinkGPT

llm = ThinkGPT(model_name="gpt-3.5-turbo")ข้อมูลโค้ดนี้เริ่มต้นอินสแตนซ์ ThinkGPT ใหม่ด้วยโมเดลที่ระบุ ซึ่งในกรณีนี้คือ “gpt-3.5-turbo”

ด้วยอินสแตนซ์ ThinkGPT ที่สร้างขึ้น ตอนนี้คุณสามารถสอนแนวคิดหรือข้อเท็จจริงใหม่ๆ ให้กับโมเดล AI ของคุณโดยใช้เมธอด memorize():

llm.memorize(['DocArray is a library for representing, sending, and storing multi-modal data.'])

หากต้องการเรียกคืนข้อมูลที่จดจำไว้ คุณสามารถใช้เมธอด memory() ดังนี้:

memory = llm.remember('DocArray definition')

เมื่อโมเดล AI ของคุณได้เรียนรู้ข้อมูลบางอย่างแล้ว คุณสามารถใช้เมธอด Predict() เพื่อคาดการณ์หรือตอบคำถามตามข้อมูลที่จดจำได้:

llm.predict('what is DocArray ?', remember=memory)โค้ดนี้ใช้เมธอดการจำ () เพื่อดึงข้อมูลที่จดจำแล้วป้อนไปยังเมธอดการทำนาย () เพื่อตอบคำถามต่างๆ

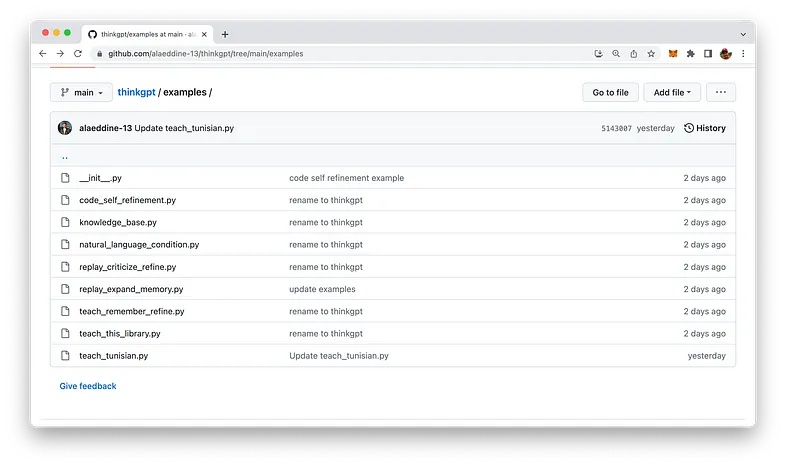

ตัวอย่างในการใช้งานจริง

ThinkGPT มาพร้อมกับตัวอย่างการใช้งานที่เข้าใจง่าย สคริปต์ Python ที่เกี่ยวข้องสามารถพบได้ในโฟลเดอร์ตัวอย่างของที่เก็บ:

ลองมาดูหนึ่งในตัวอย่างที่ให้มา: replay_expand_memory.py:

from thinkgpt.llm import ThinkGPT

llm = ThinkGPT(model_name="gpt-3.5-turbo")

# Load old memory

old_memory = [

"Klaus Mueller is writing a research paper",

"Klaus Mueller enjoys reading a book on gentrification",

"Klaus Mueller is conversing with Ayesha Khan about exercising"

]

# Teach the LLM the old memory

llm.memorize(old_memory)

# Induce reflections based on the old memory

new_observations = llm.infer(facts=llm.remember())

print('new thoughts:')

print('\n'.join(new_observations))

llm.memorize(new_observations)- ในสคริปต์ตัวอย่าง ThinkGPT นี้ เป้าหมายคือการใช้ไลบรารี ThinkGPT เพื่อกระตุ้นการไตร่ตรองหรือการสังเกตใหม่ๆ โดยอิงจากข้อมูลที่มีอยู่เกี่ยวกับ Klaus Mueller

- ขั้นแรก สคริปต์จะนำเข้าคลาส ThinkGPT จากโมดูล thinkgpt.llm

- อินสแตนซ์ ThinkGPT ใหม่ถูกสร้างขึ้นและเริ่มต้นด้วยโมเดล “gpt-3.5-turbo”

- ตัวแปร old_memory ถูกกำหนดขึ้น ซึ่งมีสามข้อความเกี่ยวกับ Klaus Mueller ซึ่งแสดงถึงความรู้เดิม

- เมธอด memorize() ใช้เพื่อสอนโมเดลภาษาขนาดใหญ่ (LLM) ข้อมูลที่จัดเก็บไว้ใน old_memory

- เมธอด infer() ถูกเรียกโดยตั้งค่าพารามิเตอร์ fact เป็นผลลัพธ์ของเมธอด memory() นี่เป็นคำสั่งให้ LLM ชักนำการสังเกตหรือการสะท้อนใหม่ตามข้อมูลที่จดจำไว้ก่อนหน้านี้

- ข้อสังเกตที่เกิดขึ้นใหม่จะถูกพิมพ์ไปที่คอนโซลภายใต้ป้ายกำกับ “ความคิดใหม่:”

- สุดท้าย เมธอด memorize() จะถูกเรียกใช้อีกครั้งเพื่อเก็บข้อมูลการสังเกตใหม่ในหน่วยความจำของ LLM ทำให้สามารถต่อยอดจากความเข้าใจของ Klaus Mueller ในการโต้ตอบในอนาคต